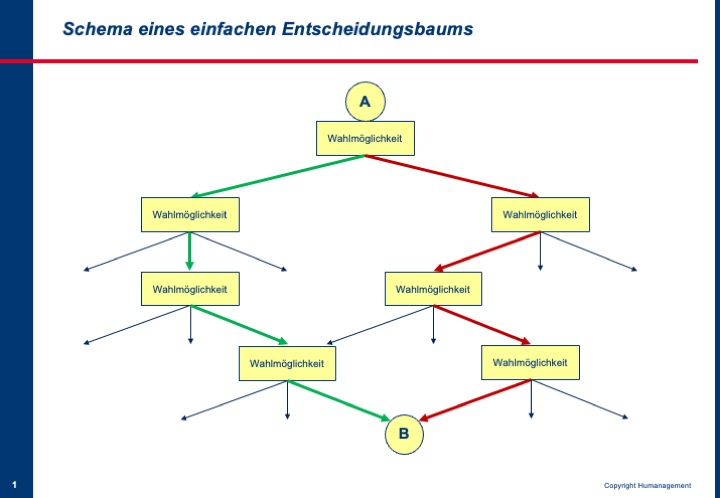

Künstliche Intelligenz folgt einfachen Regeln. Sie trifft Entscheidungen zwischen verschiedenen Wahlmöglichkeiten. Jede Wahl hat eine Konsequenz, die zu weiteren Wahlmöglichkeiten führt. So ergeben sich Entscheidungsbäume, manchmal auch Spielbäume genannt, anhand derer die KI bzw. der ihr zugrunde liegende Algorithmus mögliche zukünftige Entscheidungen und deren Konsequenzen vorausberechnen kann.

Damit der Algorithmus auch wirklich zu konkretem Handeln führen kann, muss er einen Zielzustand kennen. Der wird ihm vorgegeben. Wenn der Algorithmus weiß, wohin er mit seinen Aktionen kommen soll, dann kann er innerhalb des Entscheidungsbaums, den er anhand der Regeln berechnet hat, den Weg vom Ausgangszustand A zum Zielzustand B finden.

Im Beispiel führen zwei Wege von Ausgangszustand A zum Ziel B. Die KI kann zum Beispiel den wählen, welcher der kostengünstigste ist oder den, der am wenigsten Umweltschäden verursacht oder den schnellsten. Dazu muss man ihr diese Regel und die entsprechenden Daten vorgen.

Genau nach diesem Muster – Berechnen aller Wahlmöglichkeiten des Entscheidungsbaumes und Festlegen des optimalen Handlungswegs entsprechen der vorgegebenen Regeln vom Ausgangszustand zum Zielzustand – funktionieren die Künstlichen Intelligenzen für Brettspiele, von Tic Tac Toe über Schach bis zum Go. Ihre Überlegenheit gegenüber menschlichen Spielern gewinnen sie daraus, dass sie in der Lage sind, in kürzester Zeit Unmengen von Wahlmöglichkeiten und deren Konsequenzen durchzurechnen. Dadurch erkennen sie den Weg zum Sieg bereits zu einem so frühen Zeitpunkt, weit früher als ihr menschlicher Gegner, dass sie immer den nächsten richtigen Zug machen werden, den, der am direktesten zum Ziel führt.

So weit ist das alles ziemlich deterministisch, also eindeutig bestimmbar, und hat noch nicht so viel mit wirklicher Intelligenz zu tun. Natürlich können wir einen Algorithmus, der dieses Muster beherrscht, als intelligent bezeichnen. Es ist KI, aber eine ziemlich schwache.

Im wirklichen Leben, auch in den Fragestellungen des Unternehmensalltags, geht es aber nicht so eindeutig bestimmbar zu. Wir kennen das: Es gibt immer Ausnahmen von der Regel und Schwarz und Weiß sind selten, meist ist es irgendein Grau.

Und hier kommen jetzt Statistik und Wahrscheinlichkeiten ins Spiel. Wenn nämlich die Entscheidungen, die der Algorithmus bei einer bestimmten Aktion trifft, nur mit einer gewissen Wahrscheinlichkeit, sagen wir zu 99 Prozent, zu einer konkreten Konsequenz führt, dann kann eben in einem Prozent der Fälle auch eine andere Konsequenz eintreten. Das nennen wir dann eine Überraschung. Es besteht eine Unsicherheit, dass ein bestimmtes, vorhergesagtes Ereignis eintritt. Verschiedene Methoden der Wahrscheinlichkeitsrechnung können diese Unsicherheiten quantifizieren. Wir erhalten also eine Zahl, die uns die Sicherheit bei einer Entscheidung einschätzen lässt.

Moderne KI-Algorithmen arbeiten mit diesen Methoden und sind in der Lage, zu jedem Ergebnis die Wahrscheinlichkeit seines Eintritts ziemlich exakt zu bestimmen. Zwar benötigen sie dazu viele reale Daten, man nennt sie Trainingsdaten, und einen mitunter aufwändigen Lernprozess (dazu mehr im nächsten Blogbeitrag), aber sie schaffen Klarheit über die Sicherheit von Entscheidungen. Auf dieser Grundlage können dann Menschen entscheiden, ob und welche technischen Komponenten für das autonome Fahren zum Einsatz kommen oder ob ein bestimmter Impfstoff für den Masseneinsatz freigegeben wird.

Genau an dieser Stelle gilt ein Ausrufezeichen!

KI trifft keine sicheren Entscheidungen (wie im Übrigen auch der Mensch nicht), ist aber in der Lage, die Unsicherheit einer Entscheidung zu beziffern. Das können sie besser als wir Menschen, denn unsere intuitiven Risikoabschätzungen liegen oft total daneben. Hier kann uns KI bereichern.

Nun ist es natürlich nur recht und billig, dass die unsicherheitsbehafteten Entscheidungen von denen getroffen werden, die das Risiko am Ende tragen müssen. Und das sind in der Regel Menschen. Wir sollten also die Algorithmen nicht entscheiden lassen, wenn es wirklich wichtig ist.

Als Beispiel möchte ich das sich in den Chefetagen und Personalbereichen großer Konzerne zunehmender Beliebtheit erfreuende Social Scoring anführen. Diese Algorithmen finden zwar unter hundert Bewerbern die fünfzig für den Job geeigneten heraus, und zwar mit beeindruckenden 90 Prozent Sicherheit. Aber diese 90 Prozent sind nur oberflächlich betrachtet wirklich gut, denn bei 10 Prozent liegt die KI daneben. Diese Informationen über die Unsicherheit liegen dem Testergebnis bei, werden aber oft nicht beachtet und vor allem ihre Konsequenzen nicht berücksichtigt. Nun ist das bei den 50 geeigneten Bewerbern nicht weiter schlimm, denn sie werden in der Regel weiteren Tests unterzogen. Aber auch in der Gruppe der fünfzig abgelehnten Bewerber sind 10 Prozent falsch eingestuft. Das heißt, fünf Bewerber werden abgewiesen, obwohl sie geeignet sind. Das ist schlecht für die fünf, weil sie durch die KI um ihre Chance gebracht werden, aber auch für das Unternehmen, denn gerade unter diesen fünf hätte ja der oder die Beste sein können.

Personalchefs sollten also diese einfachen statistischen Zusammenhänge verstehen, wenn sie Social Scoring einsetzen. Oft besteht ihr Irrtum darin zu glauben, KI würde wie ein Mensch bewerten. Machen KI-Lösungen aber nicht! Sie können nicht bewerten, sondern nur sehr schnell logisch operieren und Aussagen zur Unsicherheit ihrer Ergebnisse liefern.